Cómo Monitorear los Bots de IA que Están Rastreando Tu Sitio Web (Y Por Qué Deberías Hacerlo Ahora)

Una de las interrogantes que se han dado en las últimas fechas con esto del surgimiento de los bots de rastreo de la IA y que más me han preguntado, es si estos visitan un sitio web y con qué frecuencia lo realizan.

Déjame comentarte que mientras tu lees este artículo, hay bots de inteligencia artificial rastreando tu sitio web; GPTBot, ClaudeBot, Perplexity, y docenas más están consumiendo tu contenido, usando tu ancho de banda, y decidiendo qué información de tu negocio merece estar en sus modelos de entrenamiento o aparecer como respuesta a miles de usuarios.

La pregunta no es si te están rastreando, sino qué están haciendo exactamente con tu contenido y si estás recibiendo algo de valor a cambio.

Como tu consultor, necesito que entiendas algo crucial: si no estás monitoreando estos bots de IA, estás volando a ciegas en una de las transformaciones más importantes del marketing digital de los últimos años. Y lo peor es que la mayoría de las herramientas de analítica tradicionales ni siquiera te muestran esta actividad, aunque hay algunas pocas que ya han iniciado a hacerlo.

Ahora bien no te creas en el boom de que debes de aparecer si o si en las menciones de la IA, esto apenas comienza, aun las búsquedas mediante Google, Bing o Edge siguen arriba por mucho con lo que se da dentro de la IA, sin embargo vamos a ver como puedes monitorear este tipo de visitas mediante Screaming Frog Log File Analyser para que estes pendiente y puedas verificar si apareciste mencionado por alguna IA.

Por Qué los Archivos Log Son Tu Mejor Aliado (Y Por Qué Nadie Te Lo Había Dicho)

Mira, sé que el análisis de archivos log suena intimidante, sobre todo para los SEO’s que no son muy técnicos. Muchos consultores SEO ni siquiera lo tocan porque lo consideran «demasiado técnico». Pero aquí está la verdad: los archivos log son una mina de oro que Google Analytics jamás podrá mostrarte.

Mientras Google Analytics te dice qué hacen tus usuarios humanos (después de aplicar filtros y cookies), los archivos log te muestran absolutamente todo lo que sucede en tu servidor en su forma más pura. Cada solicitud, cada bot, cada intento de acceso, cada código de respuesta.

Piénsalo así: Google Analytics es como ver el resumen editado de las noticias. Los archivos log son como tener acceso a todas las cámaras de seguridad sin editar, espero sirva la analogía.

¿Qué Son Exactamente los Archivos Log?

Los servidores donde esta hospedado tu sitio web, generan varios tipos de registros: logs de errores, logs de seguridad, y lo que nos interesa hoy, los logs de acceso. Estos registran cada petición que se hace a tu sitio web, capturando información crítica como:

- La dirección IP del visitante (o bot)

- El momento exacto de la solicitud

- La URL específica que se solicitó

- El código de estado HTTP que devolvió tu servidor

- El user agent (aquí es donde identificamos qué bot es)

- La URL de referencia

Cada línea en un archivo log representa una solicitud individual. Es granular, es completo, y es increíblemente valioso cuando sabes cómo interpretarlo.

La Explosión de Bots de IA: Un Nuevo Panorama Digital

Aquí viene lo interesante. Tradicionalmente, usábamos los archivos log para analizar el comportamiento de Googlebot o Bingbot: frecuencia de rastreo, códigos de respuesta, crawl budget, optimización de recursos del servidor, etc.

Pero ahora tenemos un ecosistema completamente nuevo de bots de inteligencia artificial, y cada plataforma tiene múltiples bots para diferentes propósitos:

OpenAI, por ejemplo, tiene:

- GPTBot (para entrenar sus modelos)

- ChatGPT-User (para buscar y citar contenido en tiempo real)

- OAI-SearchBot (para indexación)

Anthropic (Claude) tiene ClaudeBot para entrenamiento y búsqueda en tiempo real.

Perplexity tiene PerplexityBot y Perplexity-User para diferentes funciones.

Y la lista sigue creciendo cada mes con la aparición de nuevas plataformas.

Esta granularidad es fundamental porque te permite identificar qué contenido específico está siendo usado para entrenar modelos, cuál está siendo indexado, y cuál está siendo citado en respuestas en vivo a usuarios reales.

Cómo Empezar a Monitorear (Paso a Paso, Sin Tecnicismos Innecesarios)

Voy a ser práctico contigo. Aquí está exactamente cómo configurar el monitoreo usando el Log File Analyser de Screaming Frog, que es la herramienta más completa que tenemos para este propósito.

Paso 1: Consigue Tus Archivos Log

Lo primero que necesitas son tus archivos log. Contacta a tu administrador de servidor o hosting y solicita los logs de acceso. En muchos casos, si usas cPanel, Plesk o servicios similares, puedes descargarlos directamente desde el panel de control.

Si tienes personal técnico, pídeles específicamente los «access logs» del período que quieras analizar. Una semana o un mes es un buen punto de partida para identificar patrones.

Si lo realizas desde cPanel, entras a tu cuenta y buscas dentro de Archivos, la opción Administrador de archivos, al seleccionarla veras un árbol de directorios.

En este árbol de directorios ubicaras el subdirectorio logs, al dar clic en él, te mostrará todos los archivos log existentes, ubica el que corresponde a tu sitio web de fecha más reciente o bien el del mes que deseas analizar, lo seleccionas y procederás a descargarlo, este archivo viene comprimido en formato gz, por lo que tendrás que descomprimirlo para importarlo en el Screaming Frog Log File Analyzer.

Paso 2: Importar al Log File Analyser

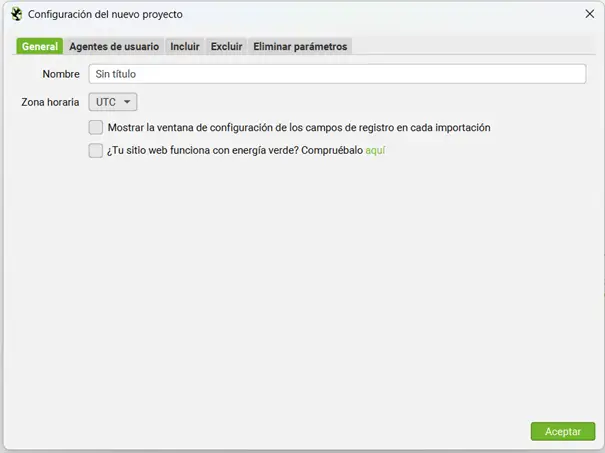

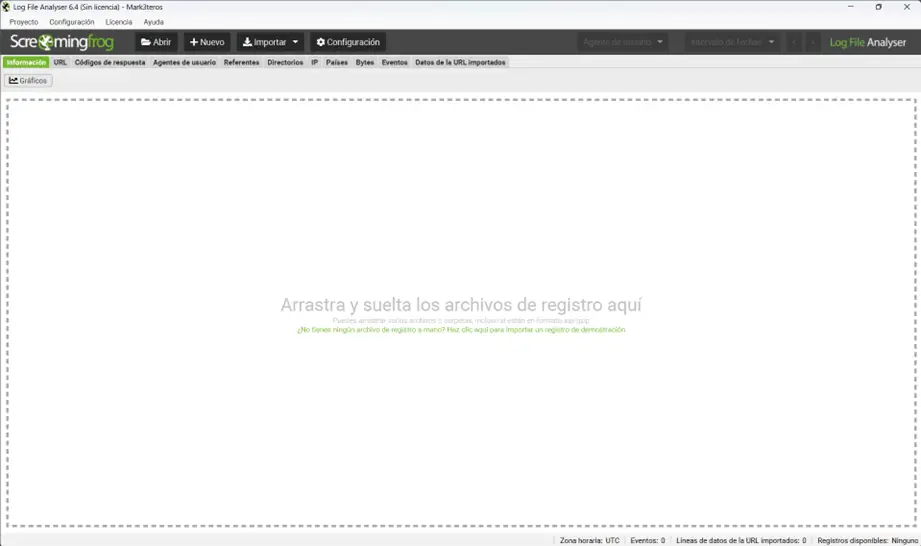

Aquí es donde todo se vuelve sorprendentemente simple. El Log File Analyser de Screaming Frog te permite arrastrar y soltar tus archivos log directamente en la herramienta. Cuando lo hagas, se te pedirá crear un nuevo proyecto.

Aquí le darás nombre a tu proyecto, normalmente es el sitio web que vas a analizar y seleccionar la zona horaria en donde dice UTC.

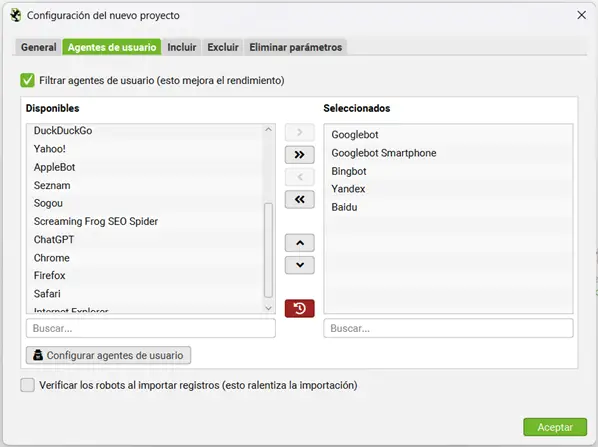

Aquí está el truco importante: Por defecto, la herramienta solo analiza los bots de motores de búsqueda tradicionales. Para monitorear bots de IA, necesitas ir a la pestaña «User Agents» y seleccionar específicamente los bots de IA que quieres rastrear.

La herramienta incluye presets para las principales plataformas: OpenAI, Claude, Perplexity, Google Gemini, y más. Simplemente muévelos al panel «Selected» con la flecha, en la versión gratuita sólo puedes seleccionar ChatGPT.

También tienes la opción de verificar que los bots son legítimos (aunque el spoofing de bots de IA es actualmente poco común, a diferencia de los bots de motores de búsqueda).

Paso 3: Analiza los Datos Como un Profesional

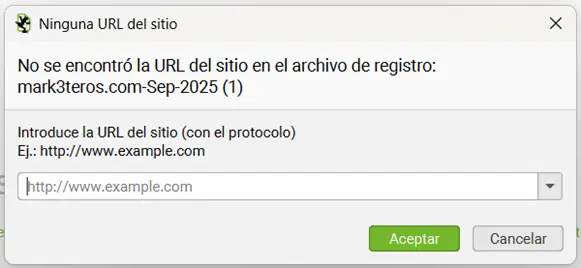

Arrastra el archivo de log que desempacaste en esta ventana, en caso de que tu log no cuente con la información del dominio a analizar te la solicitará y la ingresaras en esta ventana.

Se ingresará en el formato https://sitio.com (p.ej. https://www.mark3teros.com)

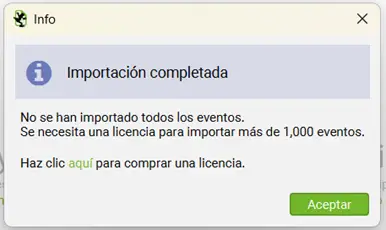

Si tu archivo log supera los 1,000 registros te aparecerá la siguiente pantalla

Para que compres la versión de paga en el enlace, para analizar con la limitante de registros le das clic en Aceptar.

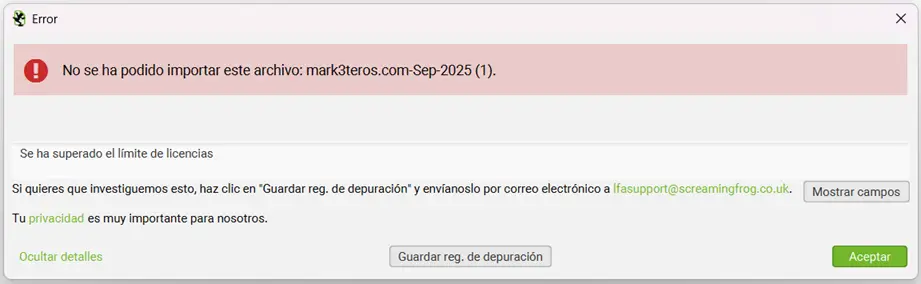

Te aparecerá la siguiente ventana si estas usando la versión de prueba.

Le das clic en Aceptar.

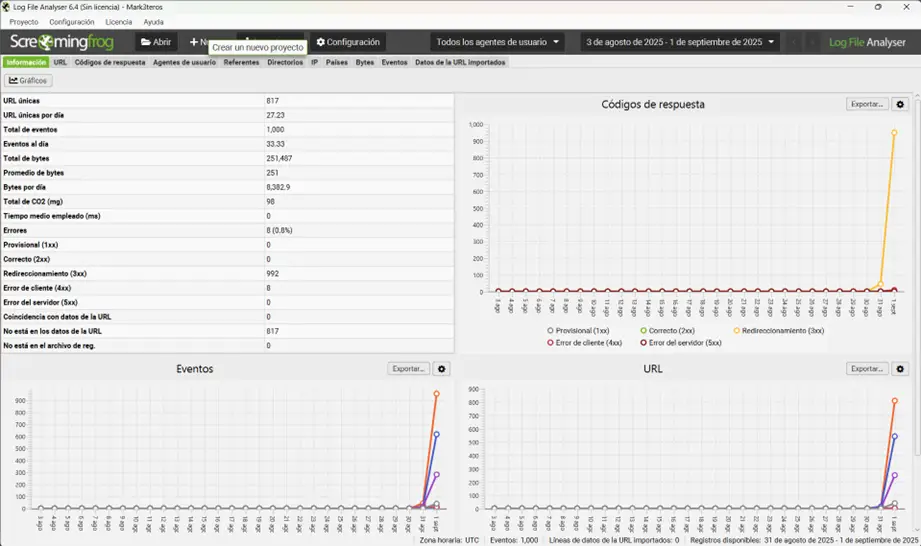

Una vez que la importación termine, vas a ver un panel de control con métricas clave: total de eventos, URLs únicas rastreadas, bytes promedio por solicitud, tiempos de respuesta, y gráficos que visualizan la actividad de rastreo a lo largo del tiempo.

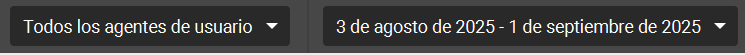

Puedes filtrar por bots específicos y cambiar las fechas usando los menús desplegables. Esto es particularmente útil para comparar comportamientos. Por ejemplo, puedes ver si GPTBot (entrenamiento) rastrea de manera diferente a OAI-SearchBot (indexación).

Las Pestañas Que Debes Conocer (Tu Nuevo Panel de Control)

El Log File Analyser organiza la información en varias pestañas. Déjame explicarte las más importantes para tu negocio:

Pestaña URLs: Muestra cada URL única descubierta en tus logs, con métricas como frecuencia de solicitudes, códigos de respuesta, bytes transferidos y tiempos de respuesta del servidor por URL. Aquí ves exactamente qué páginas les interesan a los bots.

Pestaña Códigos de Respuesta: Desglosa los códigos de estado HTTP (2XX, 3XX, 4XX, 5XX) por cada URL. Es crucial porque te permite identificar dónde los bots están encontrando problemas. La columna «Inconsistent» marca URLs que devuelven diferentes códigos de respuesta en múltiples solicitudes.

Pestaña Agentes de usuario: Agrega datos por tipo de bot, mostrando solicitudes totales, URLs únicas accedidas, tasas de error y distribuciones de códigos de respuesta para cada crawler. Perfecta para comparar comportamiento entre diferentes plataformas de IA.

Pestaña Directorios: Agrega datos por ruta de directorio, revelando qué secciones de tu estructura de sitio están explorando los bots de IA. ¿Están llegando a tu contenido más profundo o solo rastreando superficialmente?

Pestaña IP: Muestra desde que direcciones IP estan ingresando a tu sitio.

Pestaña Países: Aquí veras un desgloce de los paises que ingresan a tu sitio web por eventos, así como un mapa de calor de los paises.

Pestaña Bytes: Te mostrará por cada página la cantidad de eventos y bytes por url, así como el CO consumido (para los ecologistas).

Pestaña Eventos: Nos mostrará la marca de tiempo, la IP del host remoto, el método para obtención de datos y el código de respuesta entre otras cosas.

Pestaña de Datos de la URL importados: Aqui puedes subir un archivo en formato csv o Excel para compararlo con tu archivo de registro de log.

Qué Buscar Específicamente (Las Señales de Alerta Y Oportunidades)

Ahora que tienes los datos, déjame guiarte sobre qué significa todo esto y qué acciones tomar.

1. Códigos de Respuesta y Errores (Tu Primera Línea de Defensa)

Empieza verificando que los bots de IA estén accediendo exitosamente a tu contenido. Filtra por user-agents específicos y revisa su distribución de códigos de respuesta en la pestaña User Agents.

Números altos de errores 4XX o 5XX son señales de alarma rojas.

Piénsalo así: para bots de citación como ChatGPT-User o Perplexity-User, cada respuesta de error es una oportunidad perdida. Estos bots intentan obtener tu contenido en tiempo real para citarlo en la conversación de un usuario. Si no pueden acceder, tu sitio simplemente no aparecerá en la respuesta que reciba ese usuario potencial.

Para bots de entrenamiento (GPTBot, ClaudeBot), los errores significan que tu contenido no está entrando en sus modelos. Ahora bien, es posible que intencionalmente los bloquees vía robots.txt, pero si es accidental debido a configuraciones erróneas del servidor o reglas demasiado agresivas, estás perdiendo visibilidad sin saberlo.

También revisa la pestaña Response Codes buscando respuestas inconsistentes. Si la misma URL devuelve un 200 un día y un 404 al siguiente, hay algo que investigar.

2. URLs Más Visitadas (Qué Consideran Valioso)

Ordena la pestaña URLs por «Num Events» (solicitudes totales por URL) para ver qué páginas están accediendo con más frecuencia los bots de IA. Esto revela qué contenido consideran valioso.

Podrías encontrar:

- Artículos del blog y guías recibiendo tráfico pesado de bots de entrenamiento

- Páginas de productos siendo priorizadas por bots de citación

- Secciones completas de tu sitio siendo ignoradas

Compara esto contra lo que esperarías según tu estructura de sitio y estrategia de contenido. Si tu contenido más importante no está siendo rastreado, necesitas mejorar el enlazado interno o revisar tus reglas de robots.txt.

Diferentes tipos de bots muestran diferentes preferencias. Los bots de entrenamiento podrían favorecer contenido informativo de formato largo, mientras que los bots de citación visitan páginas específicas activadas por consultas de usuarios, que podrían ser páginas comerciales o de productos.

3. Ancho de Banda e Impacto Ambiental (Sí, Esto También Importa)

La columna Total Bytes te muestra cuántos datos está consumiendo cada bot de IA. Para sitios de alto tráfico, los crawlers agresivos de IA podrían tener un impacto notable en el uso de ancho de banda y, por ende, en costos de servidor.

El Log File Analyser calcula automáticamente la huella de carbono usando la biblioteca CO2.js, mostrando emisiones por URL. El cálculo utiliza «The Sustainable Web Design Model», que considera centros de datos, transferencia de red y uso de dispositivos.

Hemos visto evidencia de crawlers de IA haciendo cientos de solicitudes por segundo. Más allá de las preocupaciones de rendimiento del servidor, esto crea un impacto ambiental innecesario.

Si ves consumo excesivo de ancho de banda de ciertos bots, particularmente crawlers de entrenamiento que ofrecen mínimo retorno de tráfico, estos datos pueden justificar implementar limitación de velocidad o bloqueo selectivo usando robots.txt.

4. Patrones de Rastreo Agresivos (Cuando Se Pasan de la Raya)

Revisa el gráfico Events en la pestaña Overview buscando picos inusuales en la actividad de bots. Los crawlers legítimos típicamente mantienen patrones constantes y predecibles. Los aumentos repentinos podrían indicar:

- Un nuevo bot descubriendo tu sitio por primera vez

- Rastreo agresivo que podría impactar el rendimiento del servidor

- Un bot ignorando directivas de crawl-delay

Mira el Average Response Time (ms) en la pestaña User Agents. Si bots específicos se correlacionan con respuestas del servidor más lentas, podrían estar abrumando tu infraestructura. Esta es tu señal para implementar limitación de velocidad vía directivas crawl-delay en robots.txt o controles a nivel de servidor.

5. Profundidad y Cobertura del Rastreo (¿Llegaron al Buen Contenido?)

Usa la pestaña Directories para ver qué tan profundo están explorando los bots de IA tu estructura de sitio. ¿Solo están visitando páginas de nivel superior, o están descubriendo contenido varios niveles más profundo?

Una profundidad pobre de rastreo podría indicar:

- Enlazado interno débil que hace difícil descubrir contenido

- Problemas de renderizado de JavaScript (la mayoría de los bots de IA no pueden ejecutar JS como Googlebot)

- Reglas de robots.txt bloqueando inadvertidamente secciones importantes

Compara la cobertura entre diferentes tipos de bots. Si los bots de entrenamiento están rastreando extensivamente pero los bots de citación apenas visitan, estás contribuyendo al entrenamiento de modelos sin recibir ningún beneficio de visibilidad en respuestas.

El Nivel Avanzado: Combinar Datos de Rastreo con Análisis de Log

Aquí es donde realmente se pone interesante. Puedes importar datos de un rastreo del SEO Spider de Screaming Frog para comparar qué está en tu sitio contra qué están accediendo realmente los bots de IA.

Exporta la pestaña «Internal» de un rastreo del SEO Spider y arrástralo directamente a la pestaña «Imported URL Data» en el Log File Analyser. La herramienta automáticamente emparejará URLs entre tus datos de rastreo y eventos de log.

Una vez importado, usa el filtro «View» en las pestañas URLs o Response Codes para alternar entre vistas:

Matched With URL Data: URLs que aparecen tanto en tu rastreo como en tus archivos log, con datos de rastreo mostrados junto a métricas de log. Revela qué páginas detectables están siendo realmente accedidas por bots de IA.

Not In URL Data: URLs en tus logs que no se encontraron en tu rastreo. Típicamente son páginas huérfanas (sin enlaces internos), URLs antiguas que ahora redirigen, o URLs de backlinks externos que ya no existen correctamente en tu sitio.

Not In Log File: URLs de tu rastreo que no aparecen en tus logs. Estas páginas existen en tu sitio pero no han sido accedidas por los bots de IA que estás monitoreando durante el período del archivo log.

Aplicaciones Prácticas Que Puedes Implementar Ya

Encontrar Páginas Huérfanas Rastreadas por Bots de IA: La vista «Not In URL Data» revela páginas huérfanas que los bots de IA están descubriendo y rastreando, aunque no están enlazadas en tu estructura de sitio. Si contenido valioso está huérfano, pero recibe tráfico de bots de IA, considera agregar enlaces internos para hacerlo más descubrible también para usuarios.

Identificar Páginas que los Bots de IA Están Ignorando: La vista «Not In Log File» muestra páginas que existen en tu estructura, pero no han sido accedidas por bots de IA. Para páginas que quieres que los bots de IA encuentren, particularmente contenido de alta calidad adecuado para citaciones o entrenamiento, revisa por qué están siendo pasadas por alto.

Incorporar Datos de Enlaces Externos: Puedes llevar este análisis más lejos importando datos de backlinks desde herramientas como Ahrefs, Majestic o Moz. Esto te permite correlacionar popularidad de enlaces externos con comportamiento de rastreo de bots de IA. Podrías descubrir que páginas con más enlaces externos son rastreadas más frecuentemente por bots de IA.

Mi Recomendación Final Como Tu Consultor

Mira, el análisis de archivos log para monitorear bots de IA no es opcional en 2025. Es fundamental. La inteligencia artificial está cambiando cómo se descubre y se consume el contenido en internet, y si no estás monitoreando esta actividad, estás dejando decisiones críticas sobre tu visibilidad en manos de algoritmos que ni siquiera estás rastreando.

El Log File Analyser de Screaming Frog te da los datos para tomar decisiones informadas sobre el acceso de crawlers de IA. Ya sea que estés rastreando consumo de ancho de banda, detectando problemas técnicos, o validando esfuerzos de optimización, esta herramienta te proporciona la visibilidad que las herramientas tradicionales de analítica simplemente no pueden ofrecer.

Empieza hoy:

- Solicita tus archivos log de tu servidor

- Descarga el Log File Analyser (es gratuito)

- Importa y configura el monitoreo de bots de IA

- Revisa semanalmente los patrones y errores

- Ajusta tu estrategia basándote en datos reales

Recuerda: cada error 404 que recibe un bot de citación es un cliente potencial que nunca verá tu contenido. Cada rastreo fallido de un bot de entrenamiento es visibilidad perdida en la próxima generación de respuestas de IA.

La pregunta no es si puedes permitirte hacer este análisis. La pregunta es: ¿puedes permitirte no hacerlo?

¿Cómo monitorear bots de inteligencia artificial en mi sitio web?

La forma más precisa es analizando tus archivos log con herramientas como Screaming Frog Log File Analyser, donde puedes ver qué bots ingresan, qué URLs visitan y qué errores encuentran.

¿Cómo saber si GPTBot o ClaudeBot están rastreando mi web?

Revisa los user-agents dentro de tus logs. GPTBot, ClaudeBot y PerplexityBot aparecen identificados claramente y puedes filtrarlos por solicitudes, fechas y URLs accedidas.

¿Es necesario monitorear bots de IA para SEO en 2025?

Sí. Estos bots influyen directamente en si tu contenido será visible en respuestas de IA, en entrenamientos de modelos y en futuras búsquedas generativas.

¿Qué pasa si un bot de IA encuentra errores en mi sitio?

Si reciben errores 4XX o 5XX, tu contenido no será citado ni usado. Cada error es una oportunidad perdida de aparecer en resultados generados por IA.

¿Qué herramienta permite ver qué bots consumen más ancho de banda?

El Log File Analyser de Screaming Frog muestra el consumo de bytes por bot, así identificas crawlers agresivos que pueden afectar el rendimiento del servidor.

¿Necesitas ayuda para implementar el monitoreo de bots de IA en tu sitio? Como agencia especializada en SEO técnico y analítica avanzada, en Mark3teros podemos configurar todo el sistema de monitoreo, interpretar los datos por ti, e implementar las optimizaciones necesarias. Contáctanos y hablemos sobre cómo hacer que tu contenido sea más visible para la próxima generación de búsqueda impulsada por IA.

Especialista SEO y Posicionamiento Web | Consultor en Marketing Digital y Analítica WEB